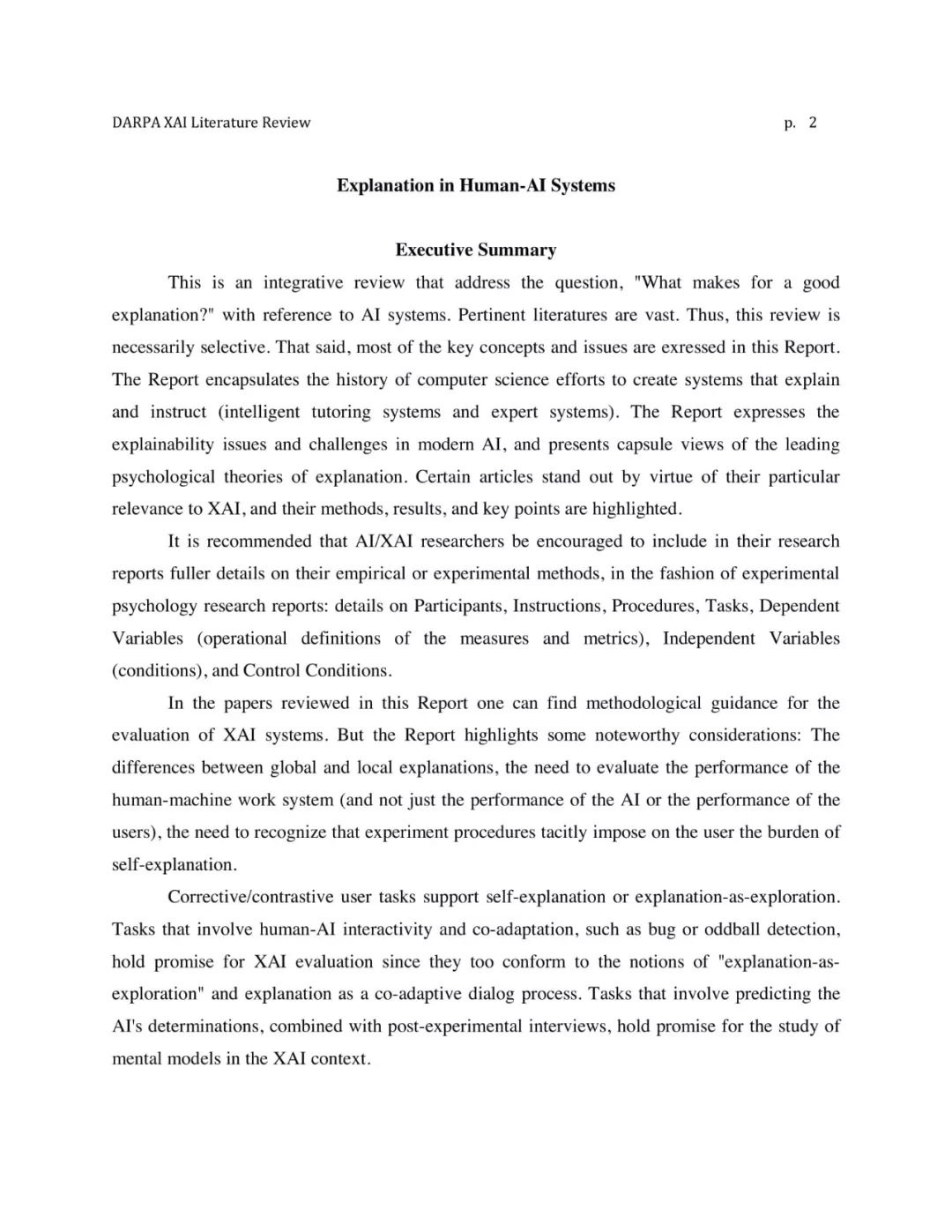

【导读】可解释AI是现在正火热的科研和工程问题。本文介绍Arxiv上的《Explanation in Human-AI Systems》,一篇关于可解释机器学习的综述,介绍了可解释机器学习的多学科观点、历史研究、模型、关键点等。

可解释AI是现在正火热的科研和工程问题。Arxiv上一篇《Explanation in Human-AI Systems: A Literature Meta-Review Synopsis of Key Ideas and Publications and Bibliography for Explainable AI》介绍了可解释机器学习的多学科观点、历史研究、模型、关键点等,PDF大概内容组织如下:

-

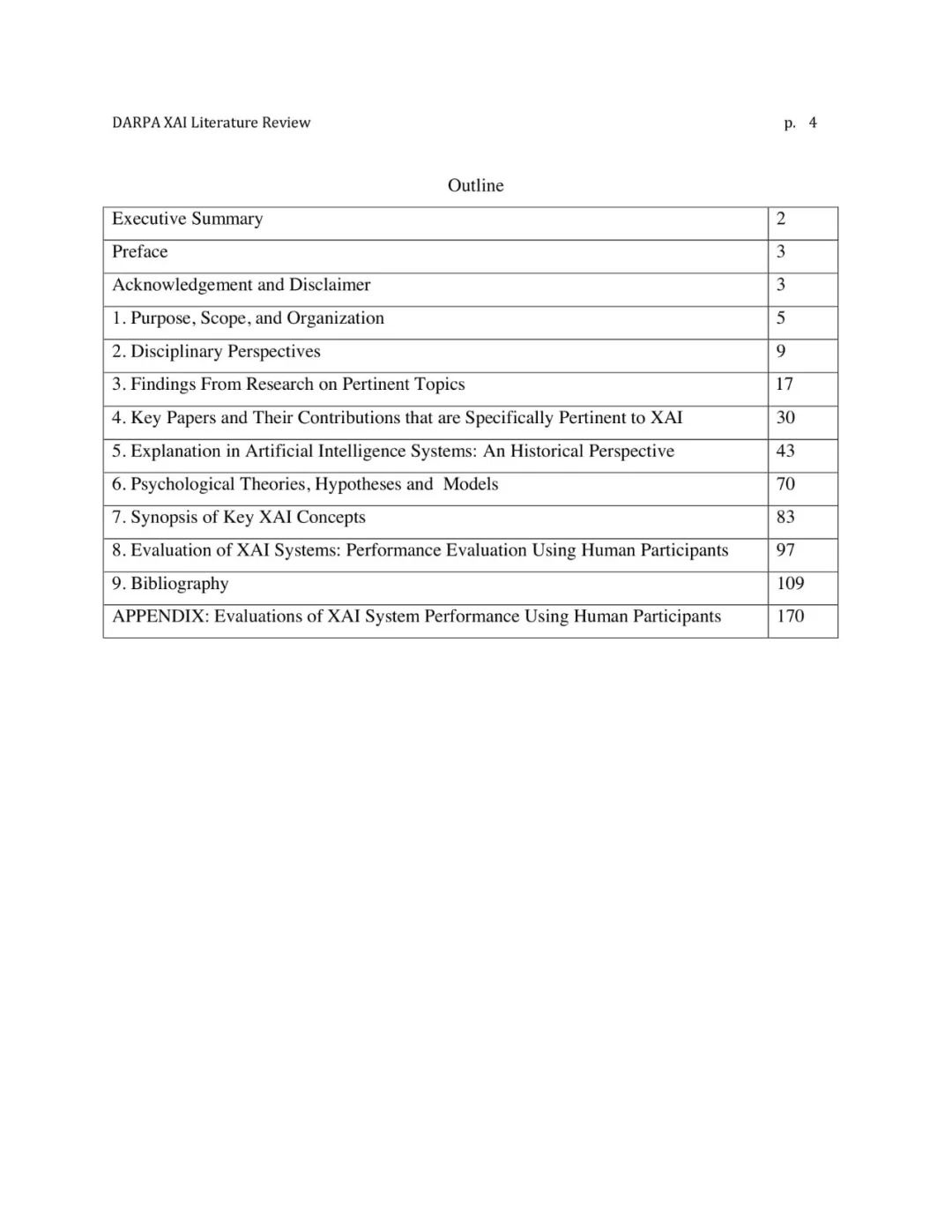

目的、范围和本文组织结构

-

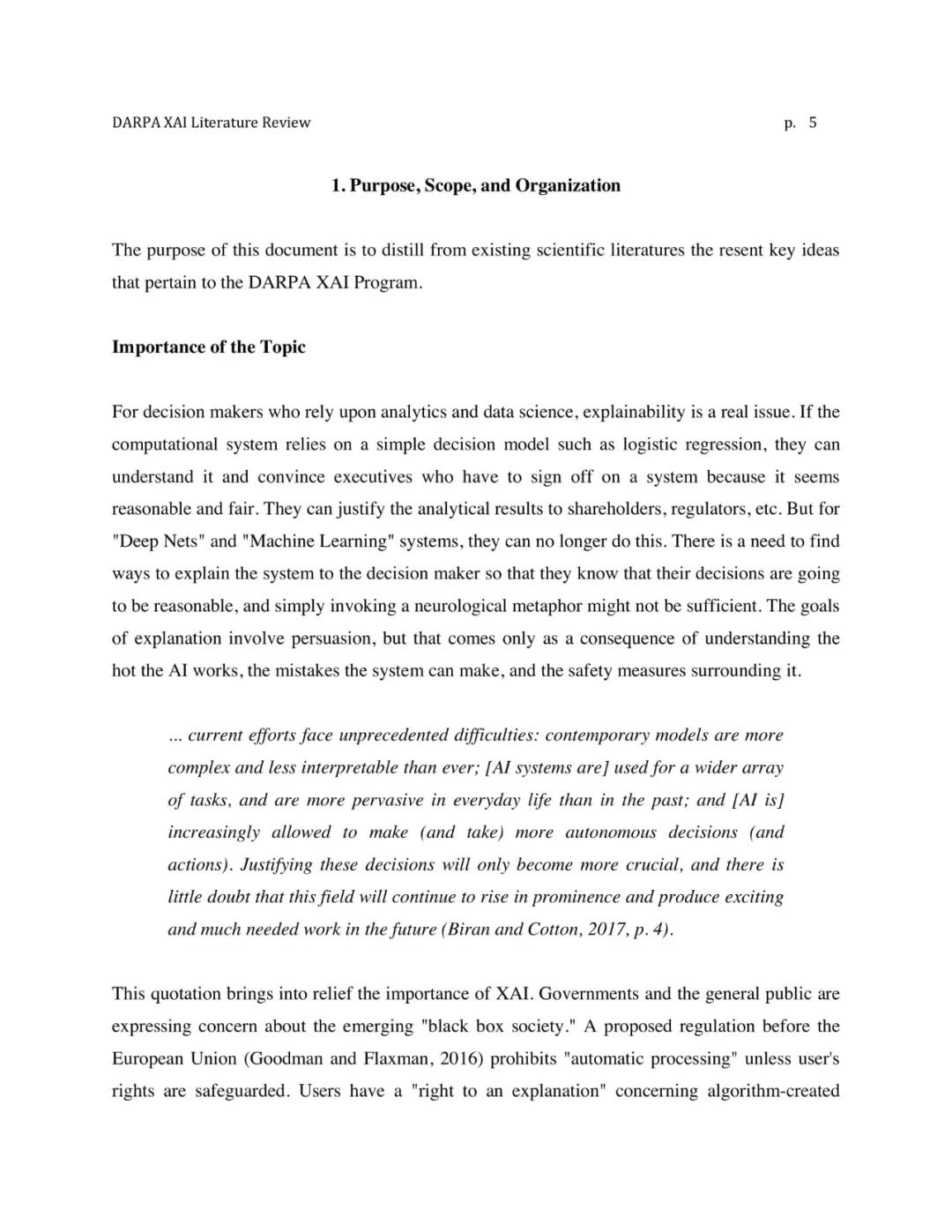

该主题的重要性

-

本文的组织结构

-

多学科观点

-

哲学

-

逻辑学观点

-

机械学观点

-

统计学观点

-

相对主义者/实用主义者的观点

-

心理学

-

可解释性与心理学

-

社会心理学

-

语言心理学

-

团队科学

-

其他人类因素、认知系统工程和决策辅助

-

考虑多学科观点的总结

-

从研究到相关主题的发现

-

以前的综述

-

公平、透明、安全、可靠、道德

-

信任

-

因果推理和外展推理

-

事件和概念的因果和机械推理

-

类比

-

理解解释

-

理解的失败和局限性

-

复杂系统的理解

-

反事实和对比推理

-

个体差异与动机

-

学习和概念形成

-

心智模型

-

前瞻推理与规划

-

对话式解释

-

自解释

-

迁移和泛化

-

关键论文和它们的贡献

-

AI系统的可解释性:历史研究的观点

-

心理理论、假设和模型

-

分类学

-

解释性与基础认知过程的关系

-

好解释的特性

-

可解释推理的局限和缺点

-

解释性推理的个体差异

-

解释的概念模型

-

心理模型的总结

-

可解释性AI关键概念的概要

-

解释的价值

-

形式和内容

-

可解释性

-

解释和证明

-

候选解释

-

心智模型

-

预期和前瞻

-

全局和本地解释

-

上下文依赖

-

对比推理

-

一致

-

好的和满意的解释

-

纠正的解释

-

信任和可靠

-

自解释

-

主动探索作为连续过程

-

解释作为协作和共同适应过程

-

测量和评价

-

可解释性AI系统的评价:人类参与的性能评价

【教程下载】

请关注专知公众号(点击上方蓝色专知关注)

-

后台回复“EHAI” 就可以获取《Explanation in Human-AI Systems: A Literature Meta-Review Synopsis of Key Ideas and Publications and Bibliography for Explainable AI》的下载链接~

部分PDF内容:

参考链接:

-

https://arxiv.org/pdf/1806.00069.pdf

-END-

专 · 知

专知《深度学习:算法到实战》课程全部完成!470+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

请加专知小助手微信(扫一扫如下二维码添加),咨询《深度学习:算法到实战》参团限时优惠报名~

欢迎微信扫一扫加入专知人工智能知识星球群,获取专业知识教程视频资料和与专家交流咨询!

请PC登录www.zhuanzhi.ai或者点击阅读原文,注册登录专知,获取更多AI知识资料!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程

ai论文润色

ai论文润色

评论前必须登录!

立即登录 注册