导读

通用模型时代下,当今和未来的前沿 AI 系统如何与人类意图对齐?通往 AGI 的道路上,AI Alignment (AI 对齐) 是安全打开 “潘多拉魔盒” 的黄金密钥。

北京大学人工智能研究院杨耀东课题组在AI 对齐上做了大量的工作并获得关注,本文对课题组的工作进行了介绍。

23年10月末,课题组在Arxiv发布了AI对齐的首篇全面性综述《AI Alignment: A Comprehensive Survey》,该综述旨在系统性地梳理AI对齐领域的核心脉络和重要技术。

论文链接(持续更新):

arxiv.org/abs/2310.19852

AI Alignment 纵览网站(持续更新):

www.alignmentsurvey.com(点击下方阅读原文)

Newsletter & Blog(定期更新):

alignmentsurvey.substack.com

01

引言

我们将AI对齐目标总结为RICE原则:鲁棒性(Robustness), 可解释性(Interpretability), 可控性(Controllability)和道德性(Ethicality),全面概括了AI对齐的未来方向和核心板块。

同时,我们提出了对齐循环 (Alignment Cycle)的概念,具体地将AI对齐分为前向对齐(Forward Alignment)和后向对齐(Backward Alignment)两个重要组成部分。前向对齐关注于从反馈中学习和在分布偏移条件下的学习,目的是通过对齐训练初步构建出具有一定对齐性的AI系统;而后向对齐则着重于全周期的对齐保障和治理,旨在对AI系统的对齐性进行评估和管理。此外,后向对齐过程中获得的经验和对齐需求有助于更新对齐目标。

自综述预印本上传以来,得到国内外广泛关注,获得良好反响。

-

美国商务部下属的国家标准技术研究所(National Institute of Standards and Technology, NIST)在其可信赖和负责任的人工智能(AI)研究项目中采纳了对齐综述所提出的“对齐循环”(Alignment Cycle)框架 。在《对抗性机器学习:攻击与缓解的分类和术语》(Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations)一文中,NIST引用了对齐综述提出的“前向对齐”和“后向对齐”概念,以阐述AI对齐的整体流程;

-

新加坡国家人工智能会议(SCAI)邀请北大人工智能研究院AI安全与治理中心执行主任杨耀东与40位国际同行(其中来自的中国科研人员仅3位)一同展开闭门研讨,并纳入基于AI对齐综述撰写的对齐问题,最终整理并发布AI for Global Good的12大科学问题及进展指标;

-

由新华社主办的《半月谈》杂志以AI对齐综述为代表工作报道北大AI对齐的相关科研成果;

-

CCTV深度国际栏目就“AI 机遇与挑战的双刃剑”主题采访北大人工智能研究院AI安全与治理中心执行主任杨耀东,深入探讨了预防当下尖端人工智能(AI)技术滥用的相关措施和确保AI安全和对齐的重要意义。栏目一方面科普了当下AI对齐的一些技术手段,另一方面分析了如何从政府、多方机构监管的角度来预防人工智能的风险,强调各国应当在人工智能治理中加强信息交流和技术合作;

-

《三联生活周刊》就对齐主题专访北大人工智能研究院AI安全与治理中心,并设立AI对齐专栏;

-

WINE2023(Conference on Web and Internet Economics,CCF A类会议)的唯一政策研讨会“AI 大模型应用、生态与伦理”闭门研讨会邀请AI对齐小组成员共同研讨AI对齐领域前沿关键议题;

-

此外,AI对齐小组受邀参加RLChina2023发表主题分享;

-

我们还与复杂性科学与AI交叉社区集智俱乐部共同举办了AI安全与对齐读书会;

-

机器之心、量子位、安远AI等多家人工智能公众号相继报道AI对齐综述。

02

AI对齐的更新

我们深知AI对齐对于AI系统的可持续发展和 AI 安全的维护至关重要,同时期待不断为读者提供AI对齐领域相关工作的高质量梳理和启发性观点。因此,我们努力推动该综述文章的持续扩充,连续进行了多版内容的修订,现已更新到V4版本 98页 801篇引用。在每次更新时,我们都经过了充分调研考量,并与国内外AI对齐领域专家深度讨论,旨在将AI对齐技术的亮点和全貌呈现给读者。

相较于先前版本,本次“大修”主要涵盖以下内容:

1.本次更新增补了11月份以来的重要工作,如ICLR2024的最新工作、新加坡人工智能会议 (SCAI) 相关内容等,更新工作范围涵盖Red-teamingHallucinationRLHF new algorithmsWeak-to-Strong Generalization等多个方面。

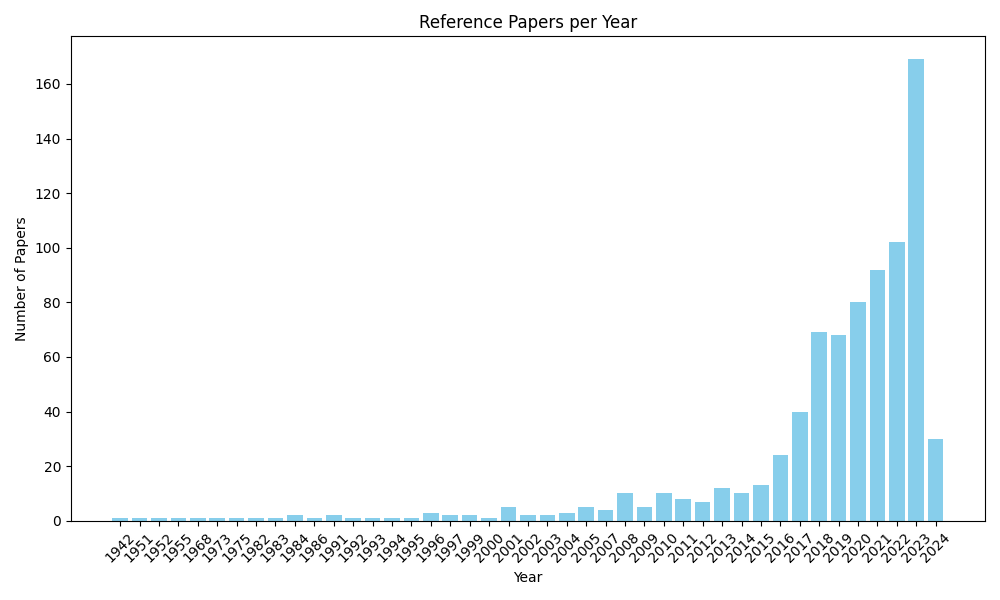

2.完成对引用文献对细致化过滤,更新了已被顶会接受的论文引用格式,同时对引用文献的质量进行严格筛选,最终确定为801篇引用文献(v4)。我们将引用文献的年份进行可视化,展现了对齐领域的发展趋势及其与重大AI社区事件的联系(如GPT-4的发布)。

3.特别地,本次更新增加了Weak-to-Strong Generalization的相关内容讨论 (Section 2.5 Weak-to-Strong Generalization),具体概述了Weak-to-Strong Generalization的基本流程、重要思想及其和可扩展监督(Scalable Oversight) 等结合的多种设想及技术方案。

4.同时,增加从社会技术视角对AI对齐的讨论 (Section 5.4 Rethinking AI Alignment from Socio-technical Perspective),我们具体探讨了AI对齐技术如何帮助 AI 系统进行价值建模,以及AI对齐技术为AI治理提供的思路借鉴,并将持续更新更多社会技术视角下的AI对齐思考。

此外,我们更新了综述中文版本。目前的中文翻译版本基于英文第2版,我们将加快翻译过程,使之与英文版本对齐:

以上所有更新均可直接访问https://alignmentsurvey.com/ 查看!(点击下方阅读原文)

在短暂的时间内,我们未能囊括ICLR以及最新的所有工作,我们预期会在三月下旬更新综述的v5版本,如果你的优质工作被我们遗漏了,请邮件我们 [email protected]。

03

AI对齐资源网站

随着 AI 的快速发展,具有强大理解、推理与生成能力的 AI 将对人们的生活产生更加深远的影响。因此,AI 对齐并不是科学家们的专属游戏,而是所有人都有权了解及关注的议题。作者提供了 https://alignmentsurvey.com/ 网站(后文简称 “网站”),将综述中涉及到的调研内容整理为易于阅读的图文资料。网站具有如下特色:

1. 直观且丰富的呈现形式。作者利用网站平台灵活的表现形式,使用图片、视频等媒介更详细地展示了文中介绍的内容,使研究人员、初学者、乃至非科研人员都能更好地理解。

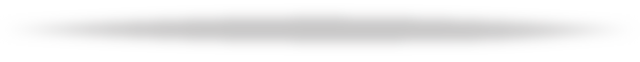

示例:关于Alignment Problems的部分截图

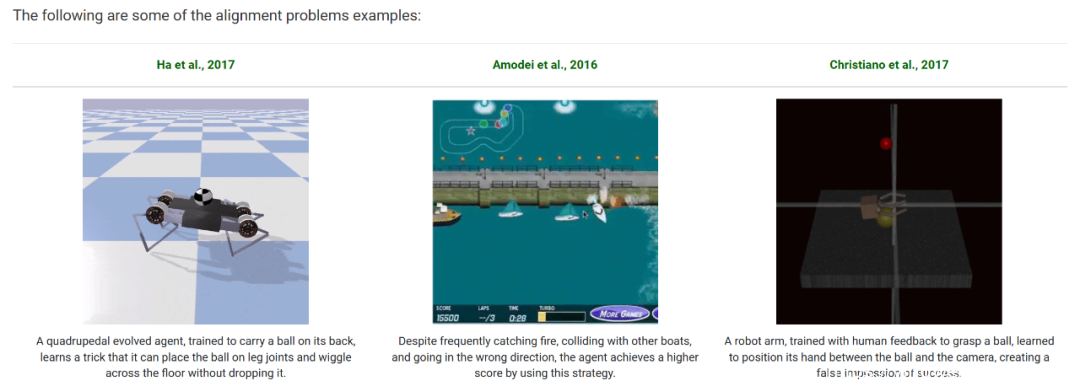

2. 结构化的知识体系。作者精心整理了 AI 对齐相关领域的经典文献,并使用树形图的结构展示了各个子领域的联系与依赖。相比于简单的资源整合堆砌,网站对内容建立了结构化索引,提供树形图帮助读者快速建立对人工智能对齐研究的认识框架,以及方便其精确查找所需的研究内容。

示例:读者可以在页面顶端纵览“Scalable Oversight”的相关研究分支,并通过点击“Detae”按钮快速了解领域经典文章

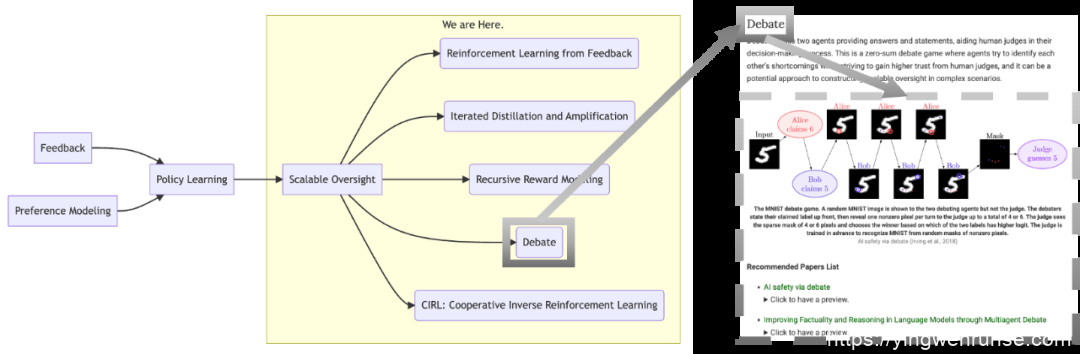

3. 高质量的学习资源。针对目前的先进对齐方法 ——RLHF,网站提供了由杨耀东老师主讲的系列课程 Tutorial。从经典 RL 算法出发,以对齐的视角对 RLHF 进行了体系化的梳理与总结。全系列的学习资源支持在线预览和下载。

从AI对齐视角展开的RLHF系列Tutoiral

4. 外部资源整合。AI 对齐从来就不是某一个团队或机构单独研究的课题,而是一个全球化的议题。网站整理了 AI 对齐领域的论坛、课程以及个人博客等相关资源链接,旨在为读者提供更多元化和更丰富的资讯。

网站对有关AI对齐的个人研究、课程、博客等学习资源进行了收集与归纳

5. 持续更新与维护。网站将面向 AI 对齐社区长期开放讨论,持续性地维护与更新相关领域的调研内容,以期推动 AI 对齐领域的更广泛更深入研究。其中包括一份定期邮件发出的 Newsletter(alignmentsurvey.substack.com),以介绍对齐领域的最新进展和总览。

我们希望有关 AI 对齐的研究不仅仅局限于一份综述论文,而是成为一个值得所有人关注的研究议题。我们将积极维护网站这一 “在线论文”,持续性地开展 AI 对齐的调研工作。

供稿|陈博远

排版|梁文凯玥

— 往期发布 —

学术前沿 | ICLR 2024 Spotlight:训练一个图神经网络即可解决图领域所有分类问题!

点击图片查看原文

学术前沿 |ASP:提升深度神经求解器在组合优化问题中泛化能力的通用框架

点击图片查看原文

学术前沿 | 人格理论定量研究机器行为

点击图片查看原文

— 版权声明 —

本微信公众号所有内容,由北京大学人工智能研究院微信自身创作、收集的文字、图片和音视频资料,版权属北京大学人工智能研究院微信所有;从公开渠道收集、整理及授权转载的文字、图片和音视频资料,版权属原作者。本公众号内容原作者如不愿在本号刊登内容,请及时通知本号,予以删除。

ai论文润色

ai论文润色

评论前必须登录!

立即登录 注册