欢迎来到专栏《AI杂谈》,顾名思义就是说一些比较杂的有意思的东西了,任何东西都有可能。

今天首先介绍一篇文章,2014年的一篇深度学习综述,《Deep learning in Neural Networks:An Overiew》,来自于瑞士人工智能实验室Jurgen Schmidhuber。这是我见过的唯一一篇参考文献比正文还长的文章(看来还是文章看得太少了),正文17页,参考文献27页。在这个基础上对深度学习的各个方向做简单的介绍。

作者 | 言有三

编辑 | 言有三

01

文章内容

顾名思义这是一篇深度学习综述文章,虽然是4年前,时间有点久远了,但是还有具有可读性的,尤其是历史部分。文章的内容包括以下几个方面。

1.1 Introduction

前面四节都是简介,加起来也只有5页纸,而且一些术语很是晦涩。

第一节简单介绍了什么是神经网络,神经网络的几个重要历史节点(1960年代的启蒙,1980年代反向传播被用于训练模型,2009年后开始逐渐在各类比赛中崭露头角等)。

提到了早期的无监督学习和有监督学习,在没有反向传播算法之前,实际上主流是采用无监督学习的方案,winner-take-all算法是很常见的。

第二节扯了没什么卵用的东西。

第三节讨论了模型深度的问题,何时shallow learning就能搞定问题,何时又需要deep learning?这是个很复杂的工程问题了,早点想一想也好。

第四节说了深度学习中的一些常见主题。提了无监督学习对有监督学习和增强学习的辅助,甚至还有GPU,不过笔者觉得写的真烂。

1.2 Supervised NNs

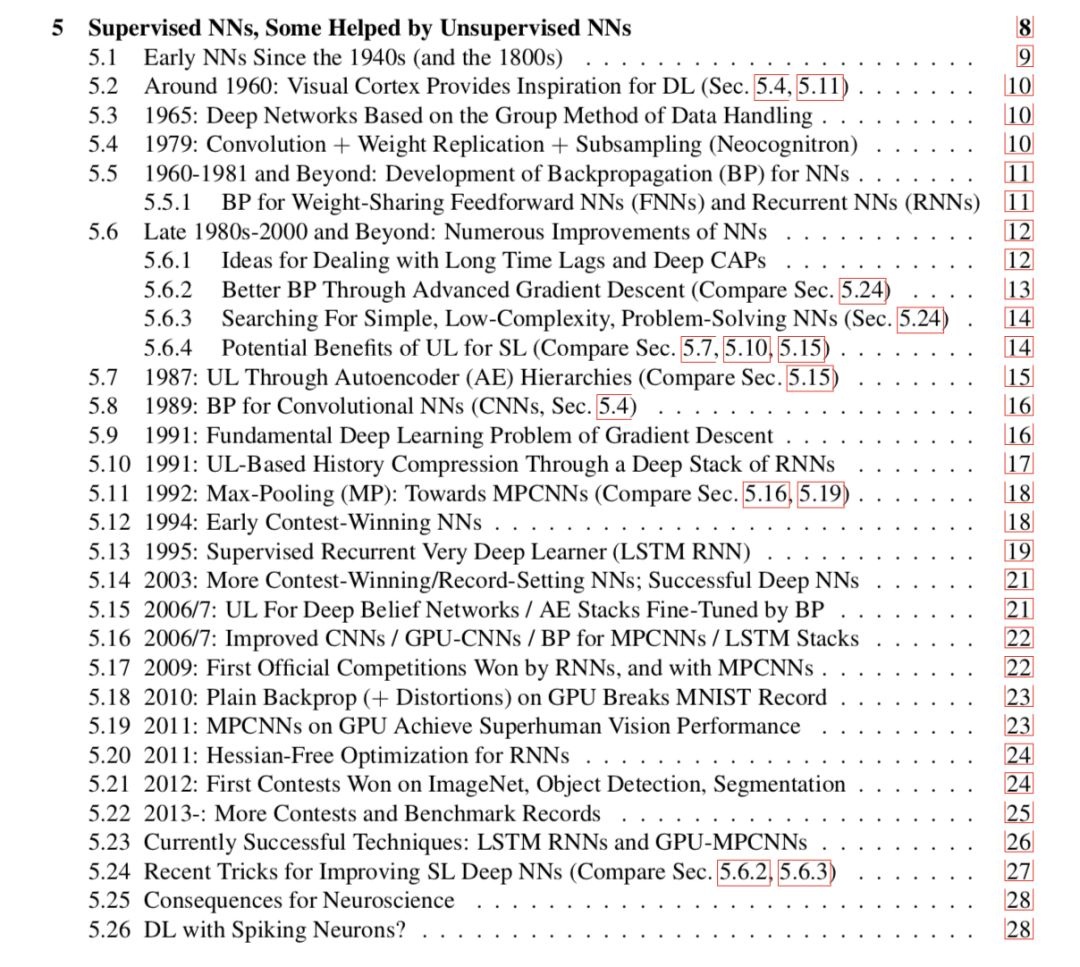

这一节才是正式开始说历史,咱们可以看一下目录了解大概。

5.1节说的是上个世纪40年代,McCulloch和Pitts提出的MP模型。

5.2节说的是上个世纪60年代Hubel和Wiesel研究猫的大脑并发现了大脑视觉机制,这是整个卷积神经网络的基础,两人也因此获得了诺贝尔生理学与医学奖。

5.3节说的是最早的多层感知器模型,甚至1971年的时候已经达到了8层,当时的机器下不知道怎么训练的,有时间要去看看。

5.4节说的是第一个卷积神经网络,Neogognitron。在这个网络中已经出现了现代卷积神经网络的基本轮廓,卷积和下采样,公众号之前也解读过的。

5.5节讲述了反向传播机制的诞生,及其在神经网络训练中的应用。正式的出现是在1981年,从此反向传播成为了神经网络的标配训练机制。

后面的大家自己对着看吧

……

……

……

1.3 Reinforcement Learning

第5部分都在说有监督学习和无监督学习在一些模式识别任务中的应用,第6部分则重点就是说增强学习在一些未知环境中的应用,并且同时讨论了前馈神经网络FNN和RNN。

02

杂谈深度学习综述

既然是杂谈就再说两句,上面这篇文章其实正文不长,但是真的不好读,在公众号写出来只是感觉比较奇特(吸引眼球)。

如果你想读深度学习或者CNN相关的综述,我推荐一些其他的资料,更好。

《What Do We Understand About Convolutional Networks?》,这是我见过最好的卷积神经网络综述,没有之一,老少咸宜,新手和菜鸟都行,覆盖CNN方方面面,有图有真相,机器之心有中文翻译版本。

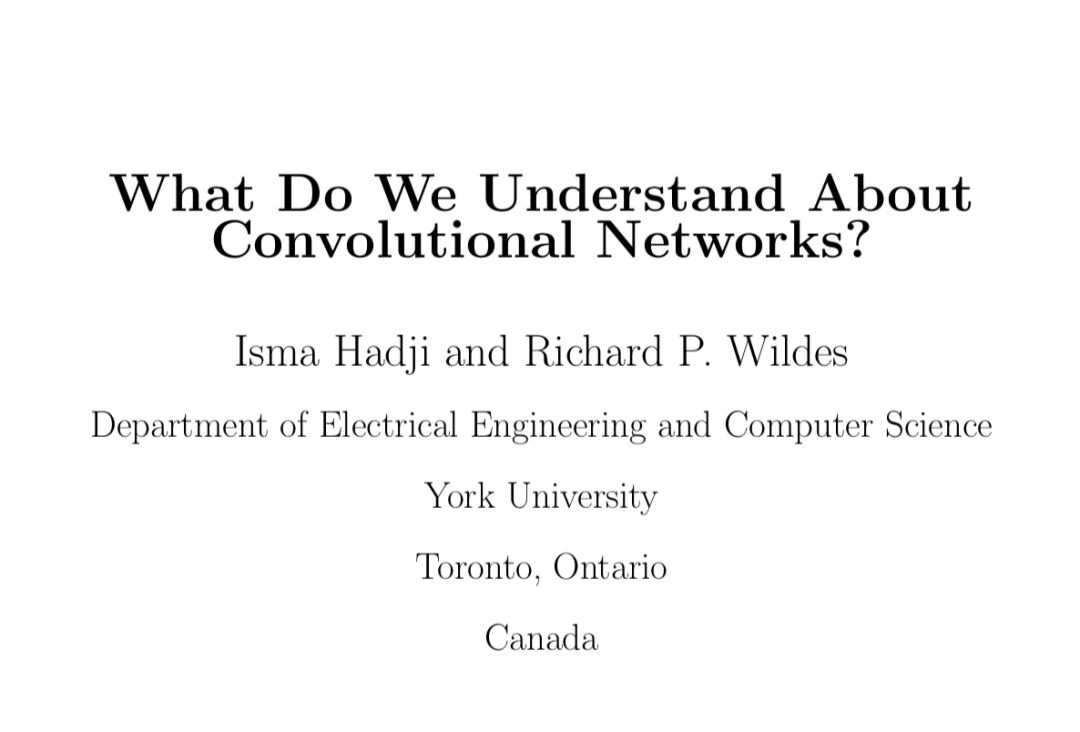

《Efficient Processing of Deep Neural Networks: A Tutorial and Survey》,主要是硬件角度出发撰写的Deep learning综述,这篇文章说的东西也比较多。

《A Deep Learning Tutorial: From Perceptrons to Deep Networks》,优秀入门博客,不多解释。

下面我对深度学习中的一些重要研究方向列出来供大家学习参考,涉及的东西太多了。

2.1 深度学习理论

深度学习相关的理论涉及非常多的东西,为大家所熟悉的就包括最优化方法,激活函数,正则化方法,归一化方法,初始化方法,可视化解释等等。

前段时间公众号也做了调研,大家对这一块内容的投票最高,之所以前段时间没写,是因为我想把这一块写的尽可能完美而浅显易懂,有理论又包含实践,这一块是我们2019年的重中之重,尽情期待吧!

2.2 模型架构

这一块包含的东西也特别多(其实可以包含在理论中),深度学习在各大领域都有不同的模型,比如图像领域常见的CNN,语音和NLP领域常见的RNN,LSTM,GAN。而CNN又包含了非常多的结构,我们有一个专栏(可以至公众号菜单看),大家持续关注就好,下面是其中的几篇文章。

【模型解读】“不正经”的卷积神经网络

【模型解读】resnet中的残差连接,你确定真的看懂了?

2.3 深度学习框架

工欲善其事必先利其器,深度学习框架对于从事相关工作太重要了,我们也有一个快速入门的专栏(可以至公众号菜单看),而且今年会进行更多的拓展,这也是公众号今年的重点项目。

【caffe速成】caffe图像分类从模型自定义到测试

【tensorflow速成】Tensorflow图像分类从模型自定义到测试

2.4 数据相关

数据是深度学习系统的输入,从数据的收集整理到数据增强的应用等涉及的领域也非常广,而且通常毁掉一个项目的就是数据,我们也有相关的专栏和文章。

【技术综述】一文道尽“人脸数据集”

【技术综述】深度学习中的数据增强(下)

【数据】深度学习从“数据集”开始

2.5 可视化

数据和模型的可视化也是一个单独的领域,可以有助于我们更深入理解数据和模型到底学到了什么,在干什么,我们也有一篇综述的。

【技术综述】“看透”神经网络

2.6 方向

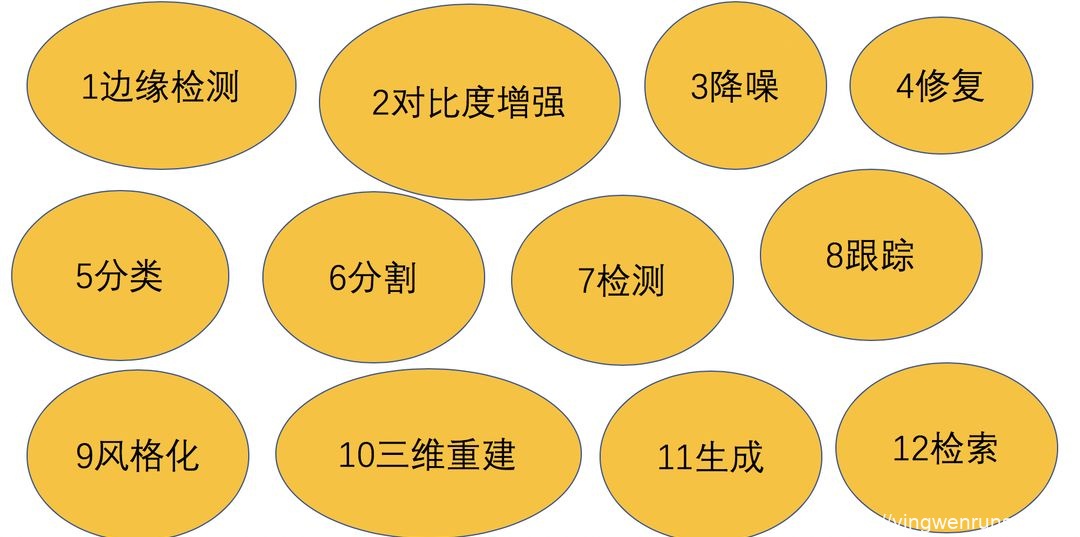

涉及的方向太广了,以图像为例,笔者以前在外讲座包括了以下内容。

当然,从应用角度来说,人脸,自动驾驶等都是非常大的方向,足够研究半辈子了。

另外,一些训练技巧,损失函数的设计等都是非常重要的工程技巧,我会经常写写的,请持续关注吧。

本文相关的文章,可以发送关键词“深度学习综述”获取。

总结

提几个小众但是很有意思的问题供大家思考一下,过一天我会公布答案。考验知识是不是扎实的时候到了。

1,谁首先提出了数据增强策略?

2,第一个图像领域的卷积神经网络和第一个语音领域的卷积神经网络分别是谁?

3,为什么LeNet网络,倒数第二层全连接的大小是84?

转载文章请后台联系

侵权必究

更多请关注知乎专栏《有三AI学院》

往期精选

-

回顾2018,计划2019

-

【杂谈】为什么你学了AI,企业却不要你

ai论文润色

ai论文润色

评论前必须登录!

立即登录 注册